2016년 한국 사회는 구글 딥마인드가 개발한 알파고와 프로 이세돌 기사의 세기적 대결을 목격하면서 최근 인공지능의 발달 상황에 대해 크게 놀랐습니다. 2022년 다양한 생성형 인공지능과 대규모 언어모델 챗GPT의 등장은 한층 더 충격적이었습니다. 생성형 인공지능과 언어모델은 일반 사람들이 직접 체험을 해볼 수 있었기 때문에 그 충격이 더욱 직접적이었습니다.

이미 인공지능은 우리 사회의 여러 분야에 도입이 되어 왔습니다. 인공지능 스피커, 번역 서비스, 배달 플랫폼, 채용 AI, 부정수급 탐지 시스템 등 공공과 민간의 여러 분야에서 인공지능이 활용되고 있습니다.인공지능은 인간의 삶을 더욱 윤택하게 할 것으로 기대를 모으고 있습니다. 그러나 국가인권위원회가 지적하였듯이, 인공지능을 무분별하게 개발·활용할 경우 시민들의 안전과 인권을 위협하고 사회 곳곳에 부정적인 영향을 미칠 수 있습니다. 인공지능이 사람을 대상으로 예측하고 결정을 내릴 때 그 부정적 영향은 치명적일 수 있습니다. 한국의 시민사회단체는 인공지능 기술 발달에 상응하여 그 위험성을 통제하는 규제 체제가 필요하다고 주장해 왔습니다.진보네트워크센터는 진보통신연합 APC의 지원을 받아, 국내외에서 논란이 되고 대안이 모색 중인 인공지능과 정보인권 문제를 알기쉽게 정리하여 소개합니다.

인공지능 기술의 발전이 빠른 속도로 진행되며 그 사용이 사회적으로 확산되고 있습니다. 그 과정에서 인공지능의 자동화된 처리에 따른 차별적이고 불투명하며 일방적인 결정으로 인한 인권 침해, 공정경쟁의 훼손, 민주적 여론형성 침해 등 다양한 문제들이 함께 발생하고 있습니다. 일부에서 인공지능이 사람보다 중립적이라는 주장을 하기도 하지만, 그것은 환상입니다. 인공지능은 수많은 데이터를 학습해 결정하는 구조이기 때문입니다. 오히려 그러한 환상 속에서 기존의 차별과 불평등을 강화할 우려가 있습니다.

사용되는 데이터에 결함이 있거나 편향적이라면, 혹은 인공지능을 개발하는 집단의 구조적 편향이 알고리즘에 반영된다면, 인공지능이 산출하는 결과물 역시 편향을 갖기 쉽습니다. 그러므로 지금 우리 사회가 이미 편향적인 생각을 갖고 있다면, 그 데이터를 그대로 흡수해 차별을 더욱 강화할 수 있는 것이 인공지능입니다.

들어가며

- 인공지능에 관한 여러 국제 인권 기준 및 국가인권위에서 발표한 인공지능 활용에 대한 인권 가이드라인은 인공지능의 활용 뿐 아니라 개발, 배치 등 전 과정에서 인권을 존중하고 보호하도록 하며, 부정적인 영향을 받은 경우 적절한 보호·구제 수단을 갖추도록 하고 있음. 그러면서 인공지능이 부정적인 편견이나 고정관념을 학습한 결과로 차별을 조장하거나 지속시킬 위험성이 있음을 지적하고, 인공지능이 사용하는 데이터의 편향, 불완전성 등에 대한 사전적 식별과 조치를 강조하고 있음.

- 인공지능은 개발 과정에서 인공지능의 학습과 고도화를 위해 방대한 데이터가 필요함. 사용되는 데이터의 품질은 인공지능의 성능에 있어서 가장 중요한 요소이기에 인공지능 개발 과정에서 데이터 수집은 필수적인 과정임. 이 과정에서 개인정보 침해도 문제이지만, 데이터가 수집되며 사회적으로 구성된 편견, 부정확성, 오류 및 실수가 포함될 수 있음. 이러한 데이터가 검증되지 않은 채 그대로 학습에 사용되면 그것을 학습한 인공지능은 편향적이고 차별적인 판단을 내릴 수 있음.

- 점점 더 고도화 되어가는 알고리즘에 의해 어떤 방식으로 데이터 편향이 발생하는지 제대로 설명할 수 없는 경우 차별을 강화·증폭할 위험이 있음. 또한 자사의 이익을 위해 의도적으로 알고리즘을 수정해 차별적 결과를 만들어내는 경우에도 영향을 받는 당사자들은 그 사실을 제대로 알 수 없음.

- 또한 자동화된 의사결정을 위해 알고리즘을 도입한 경우, 신속한 의사결정을 위해 도입한 것이므로 이전에 비해 더욱 빠른 의사결정 과정에서 차별 사실을 확인해 시정할 기회는 더욱 적어질 것임.

- 현재 차별과 혐오를 금지하는 차별금지법이 부재한 한국의 경우 이러한 알고리즘의 차별 문제는 더욱 심각해질 문제임.

- 이 글에서는 인공지능(및 알고리즘)이 특정 성별이나 집단을 차별해 문제가 된 사례를 검토해보고자 함.

구글의 알고리즘에 의한 차별 사례

- 이미 널리 알려진 사실이지만 구글의 광고와 검색결과는 무작위로 뜨는 것이 아니라 쿠키를 통해 사용자를 식별하고 사용자의 검색기록, 방문한 웹페이지, 클릭한 광고 등을 분석해 사용자의 관심사와 선호도에 맞는 광고를 선별해 보여주는 방식임. 이러한 일련의 과정에 알고리즘이 사용되며, 알고리즘과 데이터 분석을 통해 구글은 사용자 맞춤형 광고·개인화된 광고를 제공함. 그런데 이 과정에서 알고리즘 또는 알고리즘이 학습한 데이터의 문제로 인해 편파적이고 차별적인 검색 결과를 보여주기도 함.

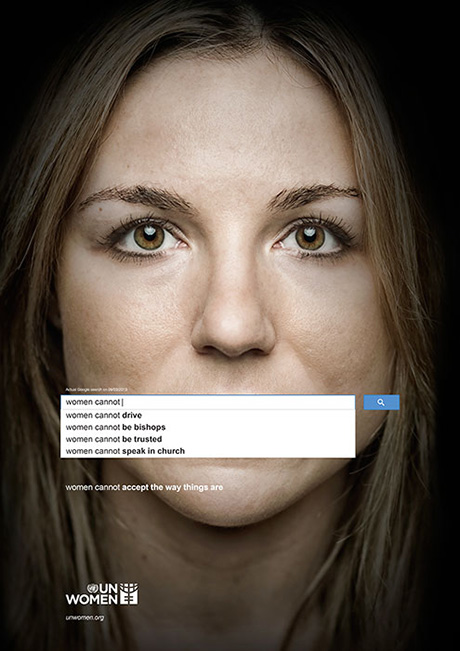

- 2013년 유엔여성(UN Women)이 발표한 성평등 캠페인 광고는 구글 검색 결과가 매우 노골적인 성차별적 내용으로 구성되어 있음을 알림. 이 광고는 미맥 오길비 앤 매더((Memac Ogilvy & Mather)라는 광고 에이전시가 만든 것으로, 당해 3월 9일 기준 구글에 “여성이 ~하면 안 된다(Women shouldn’t ~)”, “여성이 ~할 수 없다(Women cannot ~)”, “여성이 ~해야 한다(Women need to ~)”를 검색했을 때 나오는 내용들로 만들어졌음.

광고는 구글 검색 결과가 여성은 “권리가 없다”, ‘투표해서는 안 된다”, “일해서는 안 된다”, “운전을 못한다”, “믿을 수 없다”, “집에 있어야 한다”, “노예가 되어야 한다” 등 매우 노골적인 성차별적 내용임을 그대로 보여줌.

- 2013년 유엔여성(UN Women)이 발표한 성평등 캠페인 광고는 구글 검색 결과가 매우 노골적인 성차별적 내용으로 구성되어 있음을 알림. 이 광고는 미맥 오길비 앤 매더((Memac Ogilvy & Mather)라는 광고 에이전시가 만든 것으로, 당해 3월 9일 기준 구글에 “여성이 ~하면 안 된다(Women shouldn’t ~)”, “여성이 ~할 수 없다(Women cannot ~)”, “여성이 ~해야 한다(Women need to ~)”를 검색했을 때 나오는 내용들로 만들어졌음.

출처 : Ad series for UN Women, Memac Ogilvy & Mather Dubai, 2013.11.19.

-

- 2013년 미국 하버드대 교수 라타냐 스위니(Latanya Sweeny)는 흑인들이 많이 쓰는 이름을 구글에 검색하면, 백인들이 많이 쓰는 이름으로 검색할 경우와 비교해 범죄 활동과 관련한 검색결과(예 : 전과 기록 확인 사이트)에 노출될 확률이 25%나 높다는 연구 결과를 발표했음. 이러한 연구 결과에 대하여 구글은 즉각 인종 관련 정보를 수집하지 않는다고 반박해 차별의 원인에 관하여 정확히 밝혀진 바는 없으나, 이용자 검색 행태에 기반한 구글 알고리즘이 원인으로 추측됨.

- 2015년 미국 카네기멜론 대학의 연구팀은 온라인 추적 연구를 위한 통제 실험을 자동화하는 도구를 개발해 실험을 진행했음. 연구팀은 구글에서의 통제 실험 결과, 다른 모든 조건이 동일한 상태에서 남성 계정으로 설정될 경우 여성 계정으로 설정된 경우보다 급여가 더 높은 일자리 광고에 노출되는 빈도가 더 높다고 발표한 바 있음.

- 2015년 구글은 구글 포토(Google Photo) 서비스에 이용자가 사진을 업로드하면 이미지를 자동으로 인식해 태그를 붙이는 기능을 출시함. 데이터를 분류해 라벨을 붙이는 일을 알고리즘에게 맡긴 것인데, 분류 결과에 차별적 시각이 담긴 여러 사례가 있음.

- 2015년 6월 한 흑인 프로그래머와 그의 여자친구가 함께 찍은 사진을 구글 포토가 ‘고릴라’라는 태그를 붙이는 사건이 발생함. 구글은 즉각적으로 사과하고 시정 조치를 약속했으나, 2018년 미국 기술지 와이어드(Wired)는 구글이 알고리즘을 수정한 것이 아니라 단순히 ‘고릴라’, 또 그와 유사한 단어인 ‘침팬지’, ‘원숭이’를 삭제하는 조치를 취했을 뿐이라는 사실을 밝혀냄.

- 2016년 6월, 한 미국 고등학생이 구글에 ‘10대 흑인 3명(three black teens)’이라고 검색하면 표정이 없는 수감자 3인의 머그샷이 주로 나열되는 반면, 10대 백인 3명(three white teens)이라고 검색하면 서로 어깨동무를 하고 웃는 단체 사진이 주로 나온다는 점을 발견, 이를 영상으로 제작해서 인터넷에 게시한 바 있음. 이를 영국 가디언지가 보도해 큰 논란이 일었음.

출처 : “’Three black teenagers’: anger as Google image search shows police mugshots”, The Guardian, 2016.06.09.

-

- 2020년 3월, 트위터를 통해 머신러닝 기반 이미지 분석 툴인 구글 비전 AI에서 어두운 피부색의 손이 비접촉식 체온계를 들고 있는 사진에는 ‘총’이라는 라벨링을 붙이고, 밝은 피부색의 손이 같은 체온계를 들고 있는 사진에는 ‘체온계’라는 라벨링을 붙였다는 사실이 밝혀짐. 이후 알고리즘 와치(AlgorithmWatch)에 따르면 구글은 사과문과 더불어 알고리즘을 업데이트해 ‘총’이라는 라벨링이 더이상 뜨지 않도록 했다고 밝힘. 그러면서도 구글은 ‘피부색과 관련해 시스템적 편견이 있다는 증거는 없다’고 덧붙임.

- 2022년 2월, 워싱턴 대학 연구팀은 같은 대학 타 연구팀이 2015년 CEO 등의 단어를 구글에서 검색했을 때, 성별에 따라 차별적인 결과가 나온다는 지적을 했음에도 이러한 차별이 미국에서 여전히 시정되지 않았다고 발표함. 2015년 연구는 45개 직업에 대한 온라인 이미지 검색의 결과 성별 표현이 현실과 얼마나 일치하는지 전년도 미국 노동국 통계와 비교해 평가하는 것이었는데, 구글 이미지 검색 결과 CEO를 포함한 여러 직업에서 여성은 여전히 현저하게 과소 대표되어 검색자의 가치관에 영향을 미칠 수 있다는 내용이었음.

- 구글의 알고리즘이 주로 흑인과 여성을 차별하는 결과를 보여준 것은, 구글이 해명한 대로 구글이 의도한 ‘시스템적 편견’이 아닐 수는 있음. 그러나 구글이 의도적으로 차별한 것이 아닐지라도 학습 데이터 또는 현실의 편향성이 반영된 것임.

- 위 사례의 미국 카네기멜론 대학의 연구팀은 실험 결과를 발표하며 덧붙여 “구글이 정책을 위반했다기 보다는, 대규모 자동 광고 시스템에 대한 통제력을 상실했을 가능성이 크다”고 지적한 바 있음. 그러면서 대규모 머신러닝은 예상치 못한 방식으로 작동할 수 있으니, 사용자를 차별하지 않고 투명성을 제공하는 알고리즘을 생성할 방법을 검토해야 한다고 권고하고 있음.

- 검색 결과나 이미지 태그 등이 일상에 있어서 큰 부분이 아니라고 생각할 수 있으나, 분명히 사람의 인식과 가치관에 영향을 줄 수 있는 부분임. 따라서 구글은 단순히 문제가 된 단어를 삭제하는 등의 임시방편이 아니라, 차별이 발생한 원인을 규명하고 시정하는 작업을 시작해야 함.

- CEO 이미지 검색 결과를 연구한 워싱턴 대학 연구팀이 추가로 특정 직업에 대한 인식에 검색 결과가 영향을 미칠 수 있는지에 대해서도 실험했음. 장기적인 실험은 아니었으나 조작된 이미지 검색 결과를 보여준 실험 참가자의 경우, 분명한 인식의 변화가 있었음. 연구팀은 편향된 정보에 대한 노출이 적을지라도 시간이 지남에 따라 개인의 선입견부터 채용 관행에 이르기까지 모든 것에 지속적 영향을 미칠 수 있다고 지적함.

페이스북의 차별적 광고 사례

- 2016년 10월, 미국의 탐사보도 전문매체 프로퍼블리카(ProPublica)는 페이스북 광고주가 몇몇 인종 그룹을 특정 광고에서 제외할 수 있다는 사실을 보도했음. 프로퍼블리카는 직접 집을 구하는 페이스북 회원을 대상으로 하는 광고를 구매했으며, 이 때 광고 타겟팅 도구에서 아프리카계 미국인, 아시아계 미국인, 히스패닉계를 제외하도록 설정해 집행함. 해당 광고는 구매 후 15분 만에 승인됨. 프로퍼블리카는 기사를 통해 페이스북의 이러한 광고 설정이 ① 광고주의 광고 타겟팅 도구를 사용한 차별을 금지하고 있는 페이스북 정책에 위배되며 ② 주택의 판매나 임대와 관련하여 차별적인 광고를 금지하는 공정주택법(Fair Housing Act of 1968)에도 위반된다는 점을 지적함.

- 한 달 뒤인 2016년 11월, 페이스북은 ‘차별적 광고는 페이스북에서 설 자리가 없다’며 차별 금지 정책을 개선하기 위해 노력하고 있다고 밝힘. 이후 페이스북은 2017년 2월 다시 차별을 막기 위한 절차를 강화했다고 밝혔지만, 광고주 교육 등으로 이루어져 사실상 광고주에게 책임을 돌리는 방식이었음.

- 그러나 프로퍼블리카가 2017년 11월까지 계속해서 모니터링한 결과, 인종은 물론이고 고등학생 자녀를 둔 어머니, 휠체로 경사로에 관심이 있는 사람들, 일부 국가 출신인 국외 거주자 등 특정 이용자를 배제하는 광고 집행이 여전히 가능하다는 사실이 밝혀짐.

- 프로퍼블리카의 기사에 대해 페이스북은 바로 특정 인종을 차단하는 광고를 ‘잠정적으로’ 차단한다고 발표했지만, 그 이상의 적극적인 조치는 취하지 않음.

- 2018년 3월 미국의 전국공정주택연맹(National Fair Housing Alliance) 등 단체들은 페이스북을 상대로 하는 소송을 제기했음. 1년여 만에 페이스북이 차별적 타깃 광고를 중단하기로 약속하며 사건이 합의로 종결됨.

- 이후 곧바로 미국 주택도시개발부(Department of Housing and Urban Development, HUD)가 페이스북의 광고 타겟 시스템의 공정주택법 위반에 관한 소송을 제기함.

- 결국 메타가 2022년 6월 페이스북에서 주택, 고용, 신용에 관한 차별적 광고 비즈니스 기능을 연말까지 제거하는 데 동의하여 사건이 합의로 종결됨. 2016년에 시작된 문제 제기가 6년 간 이어진 것임.

- 한편, HUD가 제기한 소송은 주택 광고에 대한 것이었지만 위 합의 내용을 보면 고용, 신용에 관한 광고 차별을 금지하는 것도 포함되어 있는데, 고용·신용에 대한 광고 차별도 논란이 되어왔기 때문임. 페이스북 구직 광고의 연령 차별에 대한 집단 소송이 2017년 말 이루어졌고, 2014년 4월에는 미국의 비영리 뉴스 서비스사 더 마크업(The Markup)이 그해 3월 16일부터 4월 26일까지 약 1,800명의 페이스북 뉴스피드를 조사해 91개의 광고가 특정 연령대의 이용자들에게만 노출된다는 사실을 보도한 바 있음.

- 위의 보도를 보면, 주택 담보 대출 정보 업체 홈탭(Hometap)의 주택 담보 대출 광고는 20대, 30대 초반 이용자를 배제한 채 34~64세 이용자에게만 노출되었음. 이는 페이스북 자신의 차별 금지 정책을 위반한 것일 뿐만 아니라 캘리포니아 사업장에서의 연령, 성별 등에 따른 차별을 금지하는 운루민권법(Unruh Civil Right Act)을 어긴 것임. 또한 경우에 따라서는 연방법인 공정신용정보법(Fare Credit Reporting Act, FCRA), 신용기회균등법(Equal Credit Opportunity Act, ECOA) 위반에 해당할 수 있는 사안이기도 함.

- 위 사례를 보면, 법적 소송이 이루어진 다음에서야 페이스북은 연방법이 차별을 금지하고 있는 주택, 구직(고용), 대출(신용) 광고에 대해서만 알고리즘을 수정하겠다는 조건으로 미국 정부와 합의했는데, 이는 페이스북이 알고리즘이 도출하는 결과를 수정할 수 있다는 사실을 보여줌. 그러나 페이스북은 광고 수익을 계속해서 유지하는 것에 더 관심이 있기 때문에 이를 방기한 것임.

안면인식 기술의 차별 사례

- 안면인식 기술(Facial recognition system)은 사람의 얼굴을 스캔해 식별하는 기술로, 인종과 성별에 따른 오차율 등 해소되지 않는 결함은 물론 공공장소에서 대량으로 시민들을 감시하는데 활용되며 동의 없는 생체정보 수집·활용 등 근본적 권리 침해 가능성으로 인해 논란이 되고 있음.

- 안면인식 기술은 휴대전화의 잠금을 해제하거나 특정 장소에 접근을 허용하는 얼굴 인증(authentication)부터 사람의 얼굴을 식별(identification)해 대량 감시를 가능하게끔 하는 기술까지 다양한 기술을 포괄하고 있음. 이 중에서 일명 ‘일대다 매칭’ 즉 데이터베이스로부터 특정 사람을 구별해 식별하는 기술은 공공장소에서의 실시간 대량 감시가 가능하기 때문에 매우 우려스러움.

- 미국 표준과학연구원(NIST)는 4년마다 시중에 나와 있는 안면인식 기술을 평가하는데, 인종에 따라 인식하는 정확도가 다르다는 것을 밝혀냄. NIST에 따르면 안면인식 오차율에서 남성과 여성의 차이도 크지만 젠더와 피부색을 포함하면 오차율은 더 커지며, 백인 남성과 흑인 여성의 안면인식 오차율의 차이는 IBM의 경우 0.3%와 34.7%로 무려 100배 이상임. 실제로 2019년 미국에서는 경찰이 사용하는 안면인식 프로그램의 인식 오류로 무고한 흑인 남성이 체포되었다가 풀려난 사례가 있었음. 그러나 4년이 지난 2023년에도 또다시 무고한 흑인 여성이 체포됨.

- 2020년 5월 조지 플로이드 사망 이후 경찰의 인종차별에 대한 대중의 분노가 거세지자 아마존, IBM 등 여러 회사가 프로파일링, 대규모 인권침해 등을 이유로 들며 안면인식 사업 중단을 선언했음. 하지만 아예 사업 철수를 선언했던 IBM은 3년 만에 영국 정부와 이민국에게 안면인식 기술을 제공하는 국가 생체인식 플랫폼 개발 계약을 체결했음. IBM은 이에 대해 대량 감시에 사용되는 얼굴인식이 아니라고 부인했지만, 법 집행을 위해 개인의 사진을 데이터베이스와 대조해 식별하는 ‘일대다’ 매칭 시스템이므로 이 해명은 잘못된 것임.

- 또한 2020년 7월 페이스북이 일리노이주 생체정보보호법 위반으로 거액의 합의금을 지불하게 된 뒤에도 또다시 인스타그램의 생체정보 불법 수집 혐의로 피소된 사실을 볼 때, 안면 등 생체정보 수집에 대한 위험은 해소되지 않았다고 볼 수 있음.

- 안면인식 기술은 오인식률이 높음에도 불구하고 이미 상당히 넓은 범위에서 활용되고 있어 인식률에 따른 차별이 나타날 뿐만 아니라, 오인식률이 개선되더라도 소수집단을 식별하고 통제하는데 사용되고있어 심각한 인권침해를 야기하고 있음. 이스라엘은 이미 안면인식 기술을 국경에 활용해 팔레스타인인을 자동 검문, 조금이라도 일치하지 않으면 출입을 통제하고 있음. 안면인식 기술이 소수 집단을 특정하고 차별하는 데 사용될 경우, 심각한 인권침해의 소지가 있음.

- 안면인식 기술은 민감한 생체정보를 활용하는 기술이며, 안면인식 기술을 활용하기 위해선 수많은 생체정보가 학습데이터로 필요하기 때문에 학습에 사용되는 데이터가 제대로 동의를 받은 데이터인지에 대한 문제도 발생하고 있음. 한국에서는 공공기관인 법무부와 과학기술정보통신부가 1억건이 넘는 외국인의 얼굴 사진과 내국인의 출입국 심사 정보를 학습을 목적으로 민간기업에 제공한 사례도 있음. 또한 공공장소에서 사용되는 안면인식 기술의 활용 주체가 공공기관이더라도 기술을 개발하는 주체는 민간기업인 경우가 대부분임.

- 현재 이러한 안면인식 기술 사용에 대한 명확한 기준이나 규제가 없는 상황에서 공공기관에서 급격히 증가하고 있는 공급업체와 소프트웨어의 다양성을 검증할 절차가 없음. 따라서 오인식률이 높거나 개인정보 침해의 위험이 큰 안면인식 기술이 아무런 검증 없이 공공기관에 의해 광범위하게 도입될 수 있으며, 위 사례처럼 실제 피해로 이어질 수 있음.

미국 형사사법 알고리즘 사례

- 미국 대부분의 주에서는 형사 사법 알고리즘을 도입하고 있음. COMPAS(Correctional Offender Management Profiling for Alternative Sanctions), PSA(Public Safety Assessment), LSI-R(Level of Service Inventory Revised) 등이 그것임. 이 프로그램들은 주로 알고리즘에 기반해 과거 유죄 판결을 받은 사람들의 재범 위험성을 점수로 평가하는 방식임. 그런데 프로퍼블리카에서 백인에 비해 흑인이 위험성이 높다고 판정될 확률이 두 배나 높다고 밝히며 문제를 제기했음.

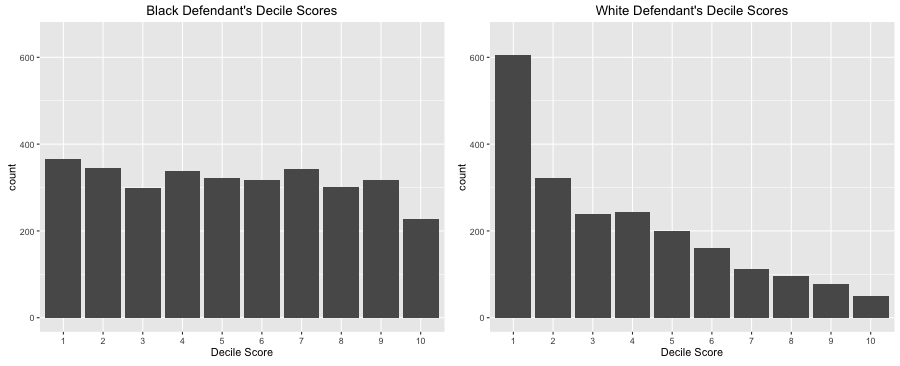

- 컴파스(COMPAS)는 피고인을 인터뷰하고 그의 형사 기록을 통해 137개의 요소(거주지, 교우관계, 마약전력, 교육 레벨, 청구서 지불 여부, 성별 등)를 추출하고 분석해 피고인의 일반범죄 재범 확률과 강력범죄 재범 확률을 1점에서 10점까지 점수로 나타내 판사에게 제공함으로써, 판사가 형량을 선고하거나 가석방을 결정하는 보조 자료로서 활용됐음. 프로퍼블리카는 기사를 통해 두 가지 통계를 제시하고 컴파스가 흑인과 백인을 차별하는 결과를 냈다고 주장했고, 제작사인 노스포인트(Northpointe)사가 반박에 나서면서 몇 차례 공방을 주고받은 바 있음.

출처: “How We Analyzed the COMPAS Recidivism Algorithm”, ProPublica, 2016.05.23.

-

- 그 중 하나는 백인의 경우 1점에 해당되는 사람이 가장 많고 고점으로 갈수록 비율이 줄어드는 반면 흑인의 경우 1점에서 10점까지 비슷한 비율로 판정을 받았다는 것임. 즉 흑인의 경우 재범 확률이 높다고 판정받은 사람들이 백인의 경우보다 훨씬 더 많았음.

출처 : 오요한, 인공지능 알고리즘은 사람을 차별하는가?, 한국과학기술학회 과학기술학연구, Vol.18 No.3 [2018], p169.

-

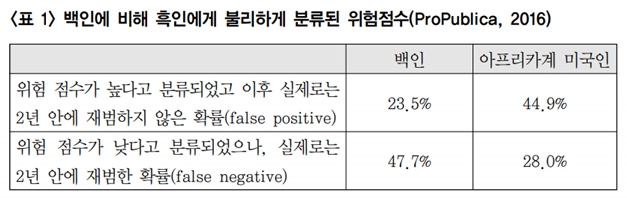

- 다른 하나는 재범 확률이 높은 것으로 예측되었지만 실제로 2년 간 범죄를 저지르지 않은 것으로 드러난 경우의 통계로 흑인이 45%, 백인이 23%로 흑인이 두 배 높았음. 또한 재범 확률이 낮은 것으로 예측되었지만 실제로 2년 간 범죄를 저지른 경우가 백인이 48%, 흑인이 28%로 백인이 두 배 높았음. 즉 흑인은 더 많은 수가 편파적으로 고위험 군으로 분류되어 위양성(false positive)이 높았으며, 백인은 더 많은 수가 저위험 군으로 분류되어 위음성(false negative)이 높았다는 것임.

- 이에 대해 컴파스를 제작한 노스포인트사는 재범 확률이 높다고 분류되었고 실제로 재범한 이의 경우 즉 진양성(true positive)은 백인 59%, 흑인 63%로 크게 차이가 나지 않았으며 실제로 재범하지 않은 이의 경우 즉 진음성(true negative)도 백인 71% 흑인 65%로 크게 차이나지 않았다고 반박함. 또한 흑인의 재범 확률 자체가 높기 때문에 위양성이 높은 것 역시 기본구성비율 자체의 차이에 의해 기인한 것일 뿐이라고 주장함.

- 프로퍼블리카는 원래 흑인과 백인의 리스크 스코어 분포가 크게 차이가 나는 것이 불공정하다고 주장했지만, 이후 논의에서는 다시 언급하지 않음. 그렇지만 “예측적 공정성이란 실로 최적의 차별” 이라는 시카고 대학교의 네이튼 스레브로의 논평을 인용하며 노스포인트사가 강조한 예측적 공정성은 결국 흑인에 대한 허위 고위험군을 더 많이 만들어내는 결과를 불러온다고 다시 비판하는 등 공방을 주고받음.

- 컴파스가 실제로 활용된 사례로 2013년 3월, 위스콘신주의 판사가 도난 차량을 운전해 경찰을 피해 도주한 혐의를 받고 있는 에릭 루미스라는 피고인에게 집행유예 없는 징역 6년을 선고하며 컴파스의 분석 결과를 인용한 바 있음. 컴파스는 루미스를 폭력 위험과 재범 가능성이 높은 고위험군으로 분류했음.

- 루미스는 1) 알고리즘을 당사자가 알 수 없으니 ‘정확한 정보에 근거해 양형을 받을 권리’를 침해하고 2) 흑인 남성을 평가하므로 ‘개별화된 양형을 받을 권리’를 침해하고 3) 컴파스에선 성별 역시 평가요소이므로 부당하다는 세 가지 이유를 들어 헌법상의 적법절차원칙에 어긋난다고 주장, 소송을 제기했음.

- 위스콘신주 대법원은 피고인이 판결 전 조사 보고서를 제공받았으며, 과거 이력 정보 및 설문 응답 결과가 사용되었음을 인지했으니 컴파스의 평가 결과에 충분히 반박할 수 있었으므로 ‘정확한 정보에 근거해 양형을 받을 권리’를 침해하지 않았고, 또한 컴파스는 양형 판단에 결정적인 요소가 아니라 부가적 정보이므로 ‘정확한 정보에 근거해 양형을 받을 권리’ 역시 침해하지 않았고 성별을 고려했다고 해도 적법절차원칙을 위반하지 않았다고 판단, 루미스의 징역형을 그대로 유지했음. 루미스는 연방대법원에 상고했으나 패소함.

- 위스콘신주 대법원은 컴파스의 사용이 적법절차원칙은 위반하지 않았다고 판단해 루미스의 형을 그대로 유지하긴 했으나, 컴파스 알고리즘의 정확성이 아직 검증되지 않은 만큼 컴파스의 평가결과를 활용하는 것이 적법한 것으로 인정되기 위해서 법원이 준수해야 하는 사용목적 및 사용방법상의 한계를 설정해야 한다고 판단함. ① 구금형(실형) 선고 여부 ② 형의 경중 판단 여부 ③ 피고인 보호관찰 판단 여부에는 사용을 금지하며, 서류에 컴파스는 작동원리가 비공개이며 개별 평가가 아니라 집단 평가이니 주의하라는 문구를 삽입하기로 함.

- 특히 형사사법과 같이 기본권 침해 우려가 큰 공권력 행사에서 차별이 발생하는 경우 개인이 받는 피해도 이루 말할 수 없지만, 공공의 신뢰가 무너지는 것도 큰 문제임. 공권력 행사에 차별의 위험이 큰 알고리즘을 도입하는 것은 위험한 일임. 시민이 형사적으로나 행정적으로 국가로부터 불이익한 처분을 받을때 그 이유에 대해 설명을 들을수 있어야 한다는 헌법상 권리인 적법절차가 침해된다면, 알고리즘의 투명성도 큰 문제가 됨. 공개되거나 검증되지 않은 알고리즘의 경우, 알고리즘에 의한 차별 문제가 발생할 경우 그 당사자에게 그 처분의 이유를 설명하기가 어렵기 때문임. 컴파스와 같은 형사사법 분야 인공지능이 인간 판사에게 편향된 결과를 제시하거나 나아가 인간 판사를 대신한 결과로 인해 중형을 선고받는다면, 당사자는 그러한 판단을 내리게 된 알고리즘의 판단 방법이나 근거가 무엇인지 알 수 없으니 이의제기하기가 더욱 어려울 것임.

나가며

- 인공지능이 특정 성별이나 집단을 차별해 문제가 된 사례들을 살펴보면 다음과 같은 특징이 있음.

- 학습 과정에서 데이터가 균형있게 반영되지 않거나, 현실의 불평등이 반영된 경우임. 이 경우는 여성이나 흑인에 대한 차별적인 검색 결과를 보여주거나, 왜곡된 이미지 태그를 붙이는 등의 결과를 불러옴. 이렇듯 대규모 데이터 학습을 거치는 인공지능은 사용된 데이터의 질에 따라서 소수자를 차별하는 방식으로 작동할 수 있음.

- 또는 플랫폼의 이익을 위해 의도적으로 방치 혹은 조장되었음. 특정 이용자를 배제하는 광고 집행이 가능하도록 하고 이를 최대한 오래 유지했음.

- 무엇보다 지금 당장은 알 수 없는 영향을 포함해 부정적인 영향을 가져올 수 있음에도 인공지능의 사용에 대해 명확한 기준이나 검증 없이 도입하였음.

- 인공지능이 아니라 사람이 판단을 할 경우에도 차별이 발생할 수 있음. 그러나 인공지능이 할 경우에는 차별적인 결과가 구조화되어 영속화될 위험성이 있음.

- 유럽연합 인공지능 백서에서는 “편향성과 차별은 모든 사회적 경제적 활동에 내포되어있는 원천적인 위험이다. 인간의 의사결정도 실수와 편향성에서 자유로울 수 없다. 그러나 동일한 편향성이 AI에 나타날 때에는 그 영향이 더욱 커서, 인간의 행동을 관장하는 사회적인 통제 메커니즘 없이 많은 사람에게 영향을 미치고 차별하게 된다”고 지적하고 있음.

- 인공지능과 빅데이터에 관한 책 <대량살상 수학무기>의 저자 캐시 오닐 역시 “우리 사회에 차별이 이미 내재해 있기 때문에 알고리즘에도 차별이 발생할 수밖에 없다”고 말한 바 있음.

- 앞서 언급했듯이 한국에는 차별금지법이 없고 선진국과 비교했을 때 인공지능을 올바르게 규제하기보다는 산업 진흥에 치우쳐진 면이 있음. 또한 인공지능을 각각의 정부 부처와 기관이 소관 업무와 관련된 부분만을 개별 이슈로 접근하고 있는 상황임. 이런 상황에서는 인공지능에 의한 차별이 발생했을 때 당사자가 구제받거나, 알고리즘을 차별하지 않는 방향으로 수정하기 어려울 수 있음.

- 알고리즘 차별로 인한 문제를 완화하기 위해서는 국가인권위의 인공지능 개발과 활용에 관한 인권 가이드라인에도 담긴 ▲인공지능의 개발 및 활용 과정에서 인권영향평가의 수행, ▲데이터와 알고리즘의 투명성, ▲활용 과정의 모니터링, ▲인공지능의 영향을 받는 사람들의 권리(거부권, 설명요구권 등) 보장 등 제도적인 안전장치가 마련되어야 함.